- Istimewa

Confluent dan Databricks Bermitra Dorong Era Baru Real-Time AI

Delta Lake, lapisan penyimpanan format terbuka yang dipelopori oleh Databricks, pada awalnya dikembangkan untuk kasus penggunaan streaming dengan penulisan yang cepat.

Hal ini telah menjadi format lakehouse yang paling banyak diadopsi, terbukti dalam skala besar - memproses lebih dari 10 exabyte data setiap hari.

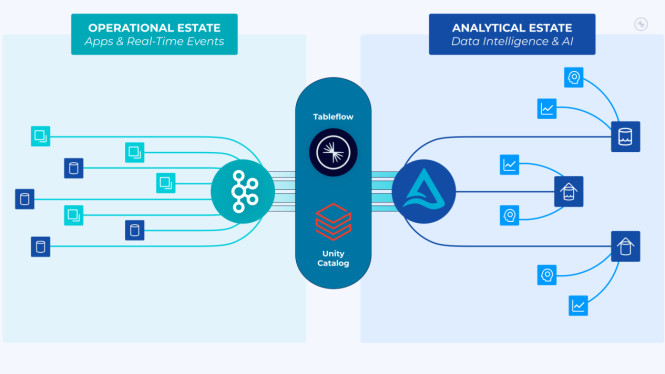

Tableflow dengan Delta Lake membuat data operasional tersedia langsung ke ekosistem Delta Lake yang lebih besar.

Pelanggan Confluent dan Databricks akan dapat membawa mesin atau alat AI apa pun seperti Apache Spark, Trino, Polar, DuckDB, dan Daft ke data mereka di Unity Catalog.

Integrasi khusus antara Tableflow dan Unity Catalog Databricks akan memastikan metadata - enabler penting untuk aplikasi AI yang secara otomatis diterapkan pada data yang dipertukarkan antar platform.

Hal ini membuat data operasional dapat ditemukan dan ditindaklanjuti oleh para ilmuwan dan analis data yang bekerja di Databricks sekaligus memastikan data analitik dapat diakses dan berguna bagi para pengembang aplikasi dan teknisi streaming di Confluent.

Selain itu, rangkaian Stream Governance Confluent akan menyediakan tata kelola hulu dan metadata untuk meningkatkan tata kelola yang mulus, end-to-end stream lineage dan pemantauan kualitas data otomatis di Unity Catalog.

Topik Terkait

Saksikan Juga

Konten Rendang Willie Salim Tuai Kontroversi

-

News

- 25/03/2025

4 Ruko Terbakar Hebat Gegara 'Bocil' Main Petasan

-

News

- 25/03/2025

Pelabuhan Merak Mulai Ramai Pemudik

-

News

- 25/03/2025

Jangan Lewatkan

Ole Romeny Jaga Asa Timnas Indonesia, Skuad Garuda Memimpin 1-0 atas Bahrain di Babak Pertama

-

Timnas

- 25/03/2025 - 21:34

Tak Ditutupi, Patrick Kluivert Bicara Jujur soal Kualitas Suporter Timnas Indonesia: Saya Rasa Para Suporter…

-

Timnas

- 25/03/2025 - 21:32

Cak Imin Sentil Ormas Paksa Minta THR: Hanya Berlaku Buat yang Kerja!

-

Ekonomi Bisnis

- 25/03/2025 - 21:29

Oxford United, Nih Bos! Netizen Minta Ole Romeny Patenkan Selebrasi Usai Cetak Gol ke Gawang Bahrain

-

Timnas

- 25/03/2025 - 21:29

Bukan Cuma Apple, Perusahaan Teknologi Kelas Raksasa AS Juga Siap Investasi ke Indonesia

-

Ekonomi Bisnis

- 25/03/2025 - 21:17

Presiden Prabowo Subianto Serius Kejar Mimpi Tinggi Timnas Indonesia, Garuda Siap ke Piala Dunia?

-

Timnas

- 25/03/2025 - 21:17

Trending

Belum Keluar Keringat, Timnas Indonesia Ketiban 3 Untung Jelang Lawan Bahrain di Kualifikasi Piala Dunia 2026

-

Timnas

- 25/03/2025 - 08:42

Pulang ke Belanda Karena Cedera, Mees Hilgers Bicara Jujur soal Level Timnas Indonesia, Blak-blakan Sebut Kualitas Garuda Sebenarnya...

-

Timnas

- 25/03/2025 - 07:52

Timnas Indonesia Bikin 5 Perubahan, Patrick Kluivert Diprediksi Turun dengan Line-up Begini saat Hadapi Bahrain

-

Timnas

- 25/03/2025 - 02:08

Erick Thohir Ucapkan Kata-kata yang Bikin Bulu Kuduk Berdiri Beberapa Jam Jelang Kick off Timnas Indonesia Vs Bahrain

-

Timnas

- 25/03/2025 - 16:51

Ramalan Paranormal Jawa, Laga Timnas Indonesia vs Bahrain di Stadion GBK Nanti yang akan Menang Ternyata...

-

Trend

- 25/03/2025 - 15:13

Starting Line-up Resmi Timnas Indonesia Vs Bahrain: Joey Pelupessy Debut, Patrick Kluivert Bikin 4 Perubahan

-

Timnas

- 25/03/2025 - 19:58

Susunan Pemain Timnas Indonesia untuk Hadapi Bahrain di SUGBK Usai Mees Hilges Resmi Dipulangkan ke Klub: Trio Jay-Ridho-Justin Potensi Starter?

-

Timnas

- 25/03/2025 - 03:27

Load more